Rapporti Scansione Google Search Console: Guida Completa per Analizzare e Ottimizzare il Tuo Sito

Introduzione

Breve panoramica su Google Search Console e la sua importanza per la SEO

Google Search Console è uno degli strumenti più potenti offerti da Google per monitorare e gestire la presenza di un sito web nei risultati di ricerca. Fornisce dati dettagliati sulle prestazioni del sito, segnalando problemi tecnici e suggerendo miglioramenti per ottimizzare l’indicizzazione. Grazie a questo strumento, webmaster e specialisti SEO possono monitorare la visibilità del sito e garantire che Google riesca a scansionare e indicizzare correttamente le pagine.

Introduzione ai rapporti di scansione e al loro ruolo nel monitoraggio delle prestazioni del sito web

I rapporti di scansione in Google Search Console offrono una visione chiara di come Googlebot esplora il tuo sito web. Questi rapporti mostrano eventuali errori di scansione, URL bloccati o problemi di accessibilità, fornendo informazioni utili per risolvere criticità che possono influenzare negativamente il posizionamento nei motori di ricerca. Analizzare e ottimizzare questi rapporti è fondamentale per garantire che Google possa accedere facilmente ai contenuti del sito.

Obiettivo dell’articolo

L’obiettivo di questo articolo è spiegare in dettaglio come utilizzare i rapporti di scansione di Google Search Console per migliorare l’indicizzazione e la visibilità del sito web. Attraverso un’analisi approfondita, imparerai a interpretare i dati, identificare e risolvere problemi tecnici, e adottare strategie SEO efficaci per ottimizzare il tuo sito web. Proseguendo, esploreremo ogni aspetto dei rapporti di scansione e come sfruttarli al meglio per potenziare la tua presenza online.

Cos’è Google Search Console e Perché è Importante?

Definizione di Google Search Console

Google Search Console è una piattaforma gratuita offerta da Google che consente ai proprietari di siti web di monitorare e ottimizzare la presenza del proprio sito nei risultati di ricerca di Google. Fornisce strumenti per analizzare il traffico organico, rilevare errori tecnici e valutare l’efficacia delle strategie SEO implementate.

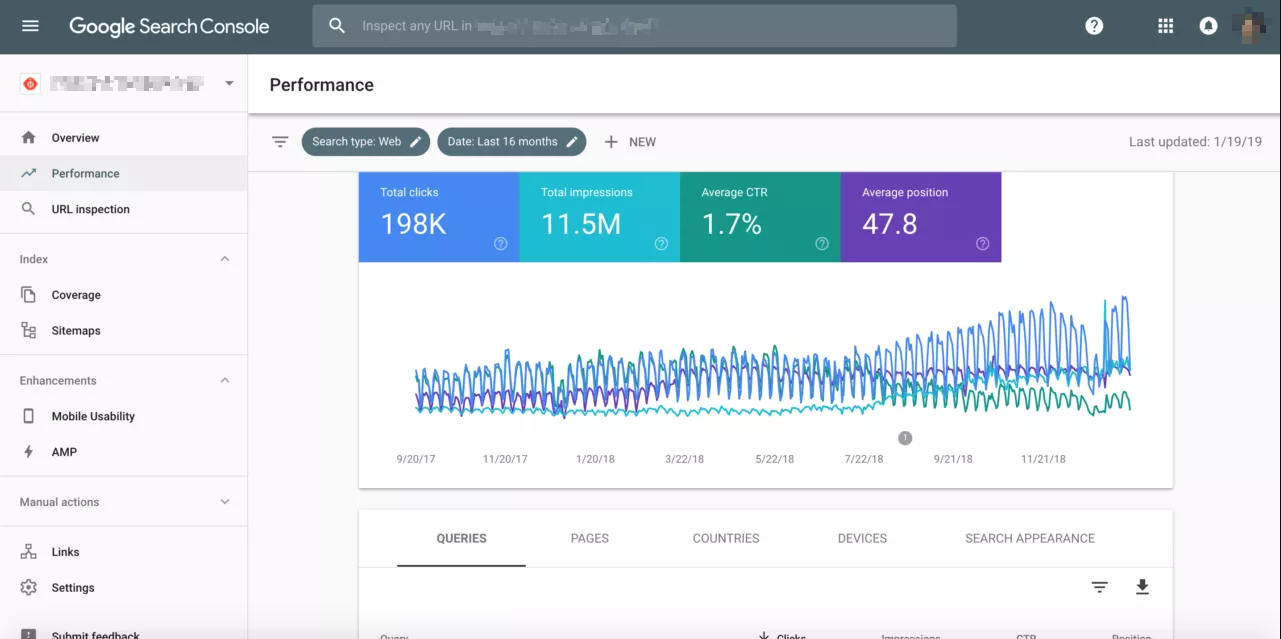

Funzionalità chiave e vantaggi per i proprietari di siti web e SEO specialisti

- Monitoraggio delle Prestazioni di Ricerca: Consente di visualizzare dati sul traffico organico, inclusi clic, impressioni, CTR (Click-Through Rate) e posizione media nei risultati di ricerca.

- Segnalazione di Errori di Scansione: Evidenzia problemi come pagine non trovate (404) e blocchi nei file robots.txt, permettendo una risoluzione rapida.

- Analisi dei Backlink: Mostra quali siti web collegano al tuo, fornendo insight per strategie di link building.

- Controllo e Indicizzazione delle Pagine: Permette di inviare sitemap XML e richiedere l’indicizzazione manuale di pagine nuove o aggiornate.

- Ottimizzazione per Dispositivi Mobili: Fornisce report sulla compatibilità mobile del sito, identificando problemi di usabilità.

- Monitoraggio della Sicurezza: Segnala eventuali problemi di sicurezza come malware o attacchi di phishing.

- Strumenti di Test per Dati Strutturati: Aiuta a verificare l’implementazione corretta dei dati strutturati per migliorare la visualizzazione nei risultati di ricerca.

Grazie a queste funzionalità, Google Search Console rappresenta uno strumento indispensabile per i professionisti SEO e i proprietari di siti web che desiderano migliorare la visibilità online e mantenere le loro pagine facilmente accessibili ai motori di ricerca.

Cosa Sono i Rapporti di Scansione in Google Search Console?

Spiegazione dettagliata dei rapporti di scansione e della loro funzione

I rapporti di scansione in Google Search Console forniscono informazioni dettagliate su come Googlebot esplora e analizza le pagine di un sito web. Questi rapporti includono dati relativi agli URL scansionati, agli errori di scansione e ai problemi di accessibilità rilevati durante il processo.

Grazie a questi dati, è possibile identificare e correggere eventuali ostacoli che impediscono una corretta esplorazione del sito, garantendo così una migliore indicizzazione e un miglior posizionamento nei risultati di ricerca.

Come i bot di Google esplorano il sito web

Google utilizza bot automatizzati, chiamati Googlebot, per esplorare periodicamente i siti web. Questi bot seguono i link presenti nelle pagine e analizzano i contenuti per determinare la rilevanza e la qualità delle informazioni. Durante questo processo:

- Raccolgono dati su ciascun URL visitato.

- Valutano la struttura del sito per comprendere come le pagine sono collegate tra loro.

- Analizzano i file robots.txt e i meta tag per determinare quali contenuti possono o non possono essere indicizzati.

Differenze tra scansione e indicizzazione

Scansione: È il processo con cui Googlebot visita le pagine di un sito web per raccogliere informazioni. • Indicizzazione: Dopo la scansione, le informazioni raccolte vengono analizzate e archiviate nel database di Google, rendendole disponibili nei risultati di ricerca.

Mentre la scansione determina quali pagine possono essere esplorate, l’indicizzazione definisce quali contenuti saranno effettivamente mostrati nei risultati di ricerca. Pertanto, un sito può essere scansionato ma non indicizzato se presenta problemi come contenuti duplicati, errori tecnici o tag noindex.

articolo suggerito: No Noindex Rilevato nel Meta Tag Robots

Capire questa distinzione è fondamentale per ottimizzare il sito e assicurarsi che le pagine più importanti siano sia scansionate che indicizzate correttamente.

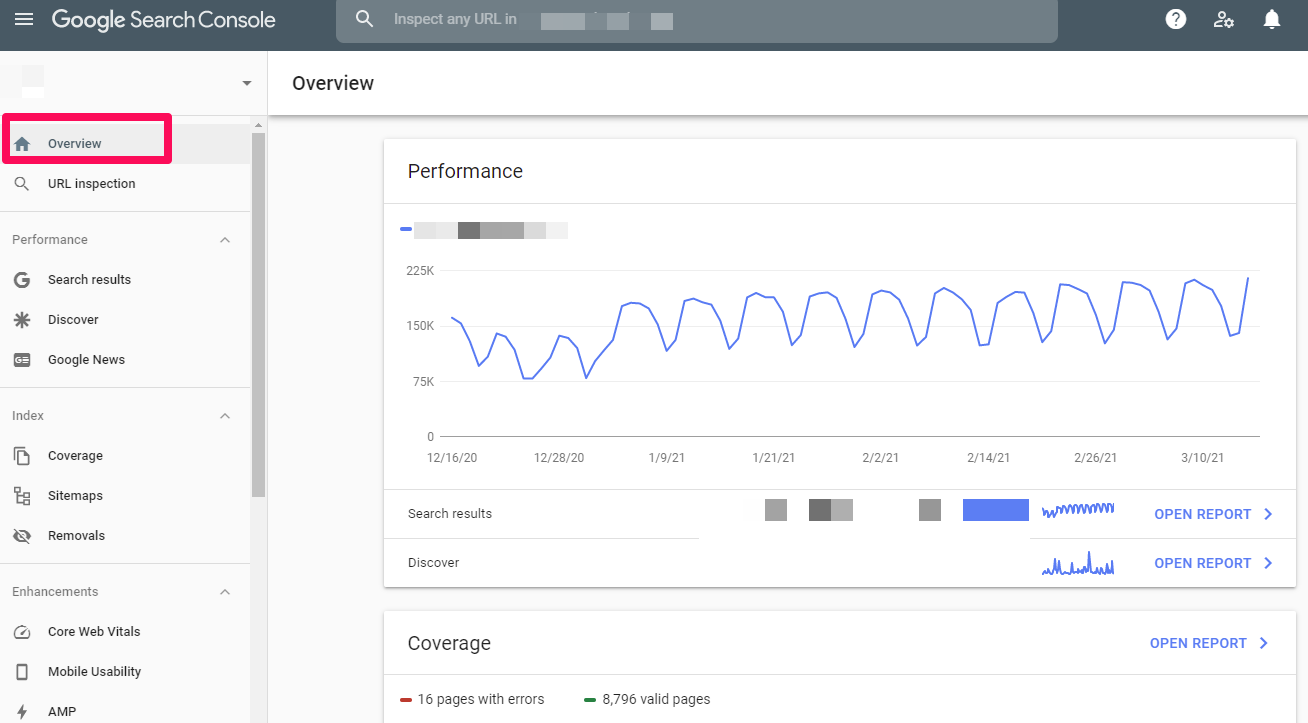

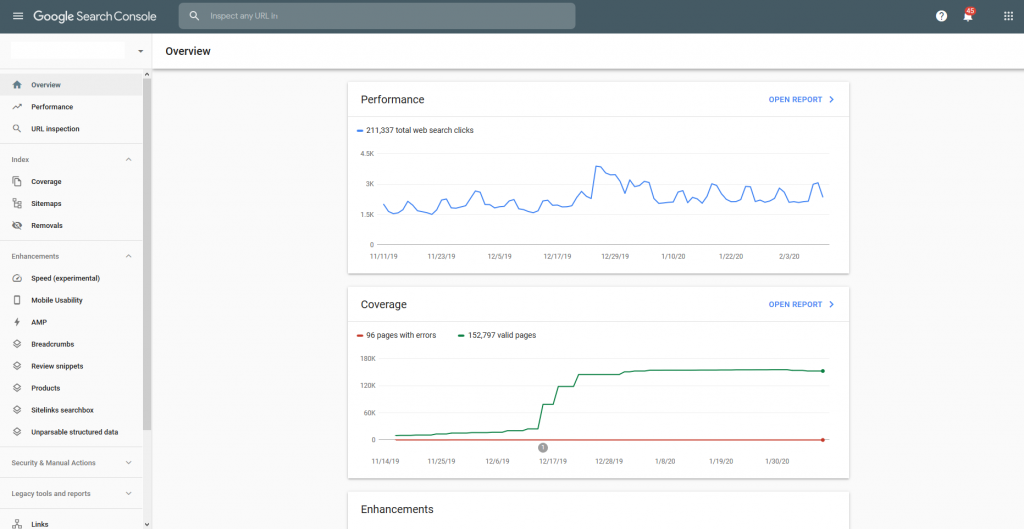

Dove Trovare i Rapporti di Scansione in Google Search Console?

Guida passo-passo per accedere ai rapporti di scansione

- Accedi al tuo account Google e vai su Google Search Console.

- Seleziona la proprietà del sito web che desideri analizzare.

- Dal menu a sinistra, fai clic su Impostazioni.

- Scorri verso il basso fino alla sezione Scansione e seleziona Statistiche di scansione.

Descrizione delle sezioni principali disponibili nel rapporto

- Statistiche di Scansione: Mostra il numero totale di richieste di scansione effettuate da Googlebot nel tempo.

- Dimensione Scaricata Media: Indica la quantità di dati scaricati durante la scansione delle pagine.

- Tempo di Risposta Medio: Fornisce informazioni sui tempi di caricamento delle pagine durante la scansione.

- Dettagli degli Errori di Scansione: Elenca eventuali errori come pagine non trovate (404), problemi di server (500) o URL bloccati.

Queste sezioni permettono di valutare lo stato di salute del sito web e identificare eventuali aree che richiedono attenzione per migliorare l’accessibilità e l’indicizzazione.

Analizzare i Dati nei Rapporti di Scansione

Interpretazione dei dati principali

- Errori di scansione: Identifica problemi tecnici come 404 (pagina non trovata) e 500 (errore del server).

- URL bloccati: Mostra le pagine che sono state impedite dalla scansione tramite robots.txt o tag noindex.

- Redirect: Controlla eventuali catene di reindirizzamento o loop che possono ostacolare la scansione.

Significato degli status HTTP e come affrontarli

- 200 OK: Pagina accessibile senza problemi.

- 404 Not Found: Pagina mancante. Risolvere creando la pagina o impostando un redirect.

- 500 Server Error: Problema tecnico sul server. Contattare l’hosting per risolvere.

Frequenza di scansione e come monitorarla

Monitorare la frequenza di scansione aiuta a identificare fluttuazioni sospette. Se la frequenza diminuisce, potrebbe essere necessario ottimizzare il server o il contenuto del sito per migliorarne l’accessibilità.

Errori Comuni nei Rapporti di Scansione e Come Risolverli

Errori 404 e pagine non trovate

Gli errori 404 si verificano quando una pagina richiesta non esiste. Per risolverli:

- Controlla se l’URL è stato rimosso o rinominato.

- Reindirizza gli URL obsoleti verso contenuti pertinenti tramite un redirect 301.

- Aggiorna i link interni ed esterni che puntano all’URL non valido.

Problemi di reindirizzamento e catene di redirect

Le catene di redirect possono rallentare la scansione e confondere i motori di ricerca. Per risolverli:

- Riduci il numero di reindirizzamenti consecutivi.

- Usa reindirizzamenti 301 diretti al contenuto finale desiderato.

- Controlla e correggi eventuali loop di reindirizzamento.

Blocco tramite robots.txt e tag noindex

Bloccando accidentalmente pagine importanti, puoi impedire l’indicizzazione. Per correggere:

- Controlla il file robots.txt per assicurarti che non stia bloccando pagine necessarie.

- Rimuovi i tag noindex non intenzionali dalle pagine che devono essere indicizzate.

- Aggiorna la sitemap XML per includere solo le pagine rilevanti.

Analizzare e risolvere questi errori è cruciale per garantire che il tuo sito sia completamente accessibile ai motori di ricerca.

Ottimizzare il Tuo Sito Utilizzando i Rapporti Scansione Google Search Console

Migliorare la struttura dei link interni

Una struttura di link interni ben organizzata facilita la navigazione e aiuta Google a scansionare e indicizzare le pagine in modo più efficiente. Utilizza anchor text descrittivi e crea collegamenti logici tra le pagine correlate.

Sfruttare la Sitemap XML per una scansione più efficiente

Assicurati che la tua sitemap XML sia aggiornata e includa tutte le pagine importanti. Invia la sitemap a Google Search Console per garantire una scansione rapida ed efficace.

Ottimizzazione delle pagine per migliorare la velocità di caricamento

Un sito veloce migliora l’esperienza utente e riduce la frequenza di rimbalzo. Ottimizza immagini, utilizza caching e riduci il codice CSS e JavaScript per migliorare le prestazioni complessive del sito.

Come Monitorare e Mantenere una Scansione Sana

1. Strumenti per Controlli Periodici e Monitoraggio Continuo

Per garantire una scansione efficiente e costante del tuo sito web, è fondamentale utilizzare strumenti di monitoraggio SEO. Alcuni strumenti utili includono:

- Google Search Console: per verificare errori di scansione e monitorare le richieste HTTP.

- Screaming Frog SEO Spider: per analizzare la struttura del sito e identificare problemi tecnici.

- Ahrefs e SEMrush: per controllare i backlink e monitorare le prestazioni generali.

L’uso regolare di questi strumenti aiuta a rilevare rapidamente errori e garantire che il sito sia sempre ottimizzato per i motori di ricerca.

2. Automazione dei Report per un’Analisi più Rapida

Per semplificare il monitoraggio e migliorare l’efficienza:

- Configurazione di Alert Automatici: Google Search Console consente di ricevere notifiche via email in caso di errori critici di scansione.

- Report Programmati: Strumenti come Google Data Studio consentono di creare dashboard personalizzate e report automatizzati.

- Integrazioni con API: Usare l’API di Google Search Console per generare report personalizzati e automatizzare le analisi.

L’automazione riduce il rischio di trascurare problemi critici e consente di intervenire tempestivamente.

3. Implementazione delle Migliori Pratiche SEO Tecniche

Per mantenere una scansione sana nel tempo, è essenziale adottare le seguenti pratiche:

- Ottimizzare il File Robots.txt: Assicurati che non blocchi pagine importanti e sia configurato correttamente.

- Utilizzare una Sitemap XML Aggiornata: Invia una sitemap sempre aggiornata per guidare i crawler verso i contenuti rilevanti.

- Migliorare la Struttura degli URL: Usa URL semplici, descrittivi e privi di parametri inutili.

- Garantire una Velocità di Caricamento Elevata: Ottimizza immagini, minimizza CSS/JavaScript e utilizza la compressione.

- Implementare HTTPS: Un sito sicuro è favorito da Google rispetto a siti non sicuri.

- Dati Strutturati (Schema Markup): Aiutano Google a comprendere meglio il contenuto della pagina.

Seguendo queste linee guida e adottando strumenti di monitoraggio avanzati, puoi mantenere una scansione efficace e migliorare continuamente la visibilità del tuo sito nei motori di ricerca.